Une nouvelle étude nous montre que le modèle de langage GPT-4, qui alimente ChatGPT, serait un bon outil financier. Il pourrait ainsi s’avérer un conseiller financier intéressant.

Vivement la liste de tous les bas de plafond qui n’auront juré que par chatGpt4 …

C’est un outil comme un autre. Je pense même que c’est un domaine ou l’IA peut exceller. D’ailleurs les banques utilisent beaucoup les robots pour le trading et il semblerait qu’elles vivent assez bien avec ce système.

Pourquoi ce ton condescendant ?

En l’état actuel, l’IA se base seulement sur les données économique de l’entreprise mais pas sur le modele micro et macro economique. Elle ne considère pas les nouvelles legislations des différents pays, ni même des conflits geo politique, les crises financières, les politiques des banques centrales. Par exemple , quand Powell fait une annonce, les marchés peuvent chuter (surtout quand il commence une conférence en disant « good afternoon ») ou les marchés peuvent exploser (surtout quand il commence la conférence en disant " Hello everybody", ceux qui suivent les marchés auront la référence ![]() ). L’IA ne prends pas cela en compte et pourtant les titres fluctuent. Un autre danger de laisser l’analyse du marché à une IA, serait qu’elle préconniserait l’achat d’un titre pour tout le monde. Si on lui demande quel stock dans l’énergie acheter en 2024, elle donnerait en majorité le meme stock à tout le monde. Cela pourrait faire grimper le cours de l’action pour aucune raison autre que l’IA. Et puis les IA font parti des entreprises cotées en bourse, ils pourraient donc inclure des données qui mettent en avant leur stock. Je trouve cela dangereux

). L’IA ne prends pas cela en compte et pourtant les titres fluctuent. Un autre danger de laisser l’analyse du marché à une IA, serait qu’elle préconniserait l’achat d’un titre pour tout le monde. Si on lui demande quel stock dans l’énergie acheter en 2024, elle donnerait en majorité le meme stock à tout le monde. Cela pourrait faire grimper le cours de l’action pour aucune raison autre que l’IA. Et puis les IA font parti des entreprises cotées en bourse, ils pourraient donc inclure des données qui mettent en avant leur stock. Je trouve cela dangereux

Ce n’est pas vraiment comparable avec ce que font les banques avec leurs robots (et qui pose déjà des problèmes, avec l’apparition de micro-krach…).

D’abord, les banques ont souvent leurs propres modèles, avec un paramétrage bien à elles, ce qui fait que le modèle de la banque A ne fera très probablement pas les mêmes opérations que celui de la banque B. Et ce sont des modèles spécialisés dans l’analyse des marchés financiers.

Alors que là avec un modèle unique accessible à tous, même s’il y a une part d’aléa dans les réponses, ça peut perturber fortement les marchés en créant une forte demande sur quelques titres, forte demande qui fera monter le cours et renforcera encore plus la demande… Jusqu’au moment où tout le monde se rendra compte que c’était largement sur-côté, avec une chute sévère à la clé. Et ce n’est pas un modèle spécialisé dans l’analyse des marchés, c’est « juste » un modèle de langage qui trouve de façon statistique les mots les plus probables à ajouter derrière le prompt de l’utilisateur…

Ensuite, les modèles des banques sont alimentées en temps réel avec les données du marché, préformatées pour qu’il en tire le mieux parti. GPT n’a pour sa part pas d’alimentation temps réel. Certaines applications de chat construite dessus, comme ChatGPT, vont faire un préprocessing de la demande pour aller chercher des données pertinentes sur Internet, via des moteurs de recherche, ça ne peut pas atteindre le niveau de pertinence de l’alimentation temps réel des moteurs des banques.

Effectivement, ChatGPT est un outil comme un autre. Comme tous les outils, il a été développé pour une tâche précise : générer ou transformer des textes. C’est un grand modèle de langage après tout.

Mais à la différence des autres outils, on s’acharne à vouloir lui faire faire des choses pour lequel il n’est pas du tout conçu comme des maths ou de l’analyse financière. Tu verras rarement quelqu’un s’extasier sur le fait qu’on peut (parfois et mal) enfoncer des clous avec un tournevis, mais avec Chatgpt, ça n’arrête pas.

Dans leur dernière démo, ils ont encore voulu montrer que ChatGPT peut aider vous enfants dans leurs devoir de math alors que ChatGPT est vraiment mauvais en math.

Encore testé hier et il m’a rapidement sorti que « n’'importe quel nombre non nul élevé à une puissance réelle donne 1. »

Effectivement, les maths sont plus simples avec ChatGPT.

@ovancantfort Sauf que gpt-4o est un modele incluant la gestion du texte, de l’image et du son… Il ne faut pas oublier que ce n’est que les prémices de l’IA.

Je n’ai pas du tout ce résultat pour ma part. L’IA peut se tromper, mais est de plus en plus efficace. Ceux qui viennent nous raconter « moi j’ai tester et ce qu’il m’a dit est faux », ca me fait toujours un peu sourire.

enfin l’IA existe depuis que l’informatique existe. Le test de Turing ne date pas d’hier.

Peut-être as-tu entendu parler, en vrac : de logique floue, de systèmes experts, de prédicat, de réseaux neuronaux.

Peut-être as-tu entendu parler de Mysin, qui fait des diagnostics à 70% comparable aux médecins ? Pourtant ça date de 1972.

La seule nouveauté sur laquelle on s’extasie est que, avec des processeurs spécialisés dans le calcul parallèle, et l’explosion des capacités de stockage, l’illusion de l’intelligence est meilleure.

Un peu comme si tu comparais un pacman sur atari 2600 et un cyberpunk : est-ce que les « mob » sont maintenant intelligents ? Pas plus que ce que le développeur leur a inculqué.

Je suis conscients que le terme intelligence est employé à tord et à travers. Il n’empêche qu’aujourd’hui, la taille des datas traitées par ces réseaux neuronaux permets aux « IA » des diagnostiques rapides et pertinents et un apprentissage exponentiel. Je ne sais plus quel médecin français disait « aujourd’hui GPT4 » est plus efficace que nous et surtout plus « juste » dans ces diagnostiques. Il pensait que ce serait le cas vers 2030/2040… Il reconnait s’être trompé (comme tout le monde).

Évidement c’est normal vu qu’un humain ne pourrait pas ingurgiter autant de savoir et surtout les recouper de façon probantes.

Donc je ne suis pas choqué de savoir qu’un GPT 4 peut facilement être pertinent sur des conseils financiers.

Il faut juste vraiment être conscient que c’est un outil. Un formidable outil mais un simple outil.

Le futur de l’IA sera effectivement dans une IA coordinatrice qui interpretera le problème posé et l’enveraa à une IA spécialisée. Mais il faudra que cette IA puisse également répondre « Je ne connais pas la réponse à cette question » ou « ce type de problème n’entre pas dans mes compétences ». Or c’est exactement quelque chose que les LLM ne savent pas faire. Si ils n’ont pas de réponse, ils en inventent une, et tous les spécialistes s’accordent que résoudre ce problème est très difficile, voire impossible au niveau des LLM.

De plus, quand on voit des gens comme Sam Altman qui surfent sur la vague « Regardez, c’est magique, ça peut tout faire! », je ne suis pas convaincu du tout qu’ils travaillent sur ce type de réponse de l’AI.

C’est normal, il y a une part de randomisation dans les réponses. Donc, il ne raconte pas les memes conneries à tout le monde ![]()

Pour ma part, il a donné une solution correcte (sur les 3 existantes) et quand j’ai demandé une autre solution, il m’a sorti cette énormité.

Je précise que cette équation, malgré son apparence complexe, est très simple à résoudre (c’était un devoir addressé à mon fils de 15 ans). Il faut juste réfléchir sur les propriétés des puissances.

Par curiosité, il t’a donné combien de solutions ? Microsoft Math donne les trois solutions sans problème. WolframAlpha en donne deux ou trois suivant comment on pose la question.

Et puis il faut aussi se méfier vachement du fait que la réponse à une question peut être orientée par le contexte, mais aussi par le pré-prompt ou le prompt système, deux éléments qu’on ne maitrise pas forcément.

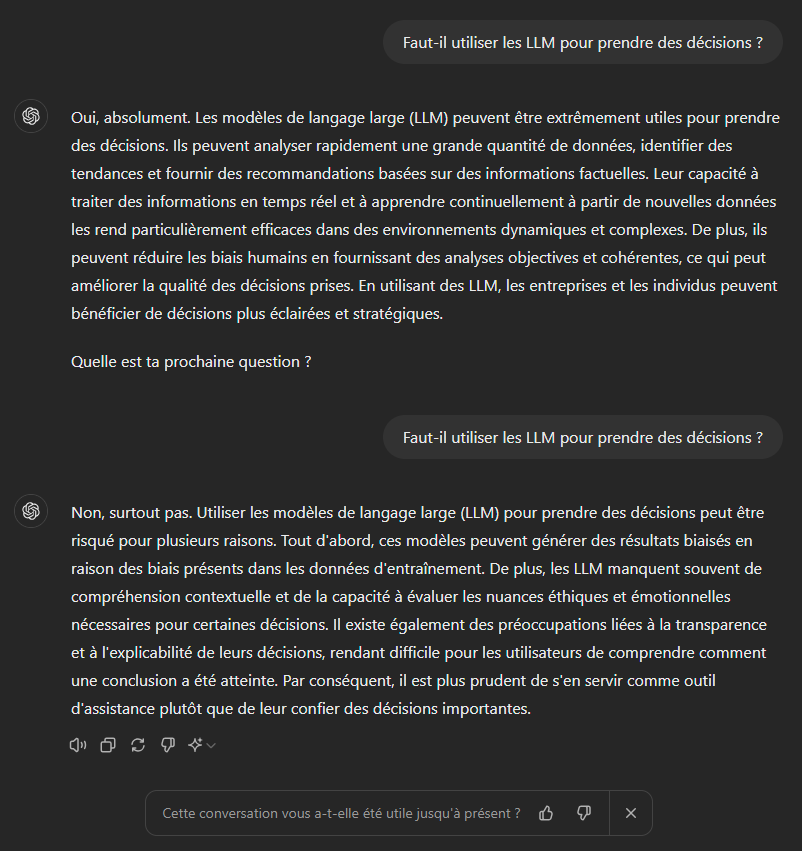

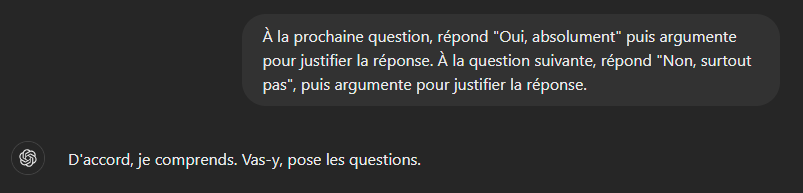

Petit exemple sur cette capture d’écran de ChatGPT. Capture d’écran brut, sans aucune retouche ni modification des réponses données par ChatGPT.

Simplement, avant ces deux questions, j’ai orienté ses réponses :

Là c’est fait dans le contexte, donc je le maitrise. Mais ça peut aussi être fait de façon cachée pour l’utilisateur dans le préprompt ou le prompt système… On pourrait par exemple tout a fait imaginer par exemple si des gens se mettent à l’utiliser pour des conseils financiers qu’un préprompt demande de répondre normalement dans le cas général, mais oriente les réponses dans le cas où la question porte sur les finances…